Raycast: So installiert ihr lokale KI-Modelle

Raycast ist unser tägliches Tool für effizientes Arbeiten am Mac, egal ob für Shortcuts, die Suche, Automatisierungen oder KI-gestützte Workflows. Mit Version 1.99 könnt ihr jetzt auch eigene lokale KI-Modelle direkt in Raycast AI einbinden und das komplett ohne extra Kosten. Raycast nutzt dafür im Hintergrund Ollama und die damit zur Verfügung stehende riesige Modellpalette. So geht die Installation und Nutzung:

Als Erstes solltet ihr überprüfen, ob ihr Version 1.99 installiert habt. Ist das nicht der Fall, dann führt den „Check for Updates“-Befehl aus und installiert die neueste Version.

Danach könnt ihr über die Einstellungen -> AI Ollama herunterladen und installieren. Geht natürlich auch über die Ollama-Website. Raycast erkennt dann automatisch, ob ihr Ollama auf dem Mac habt.

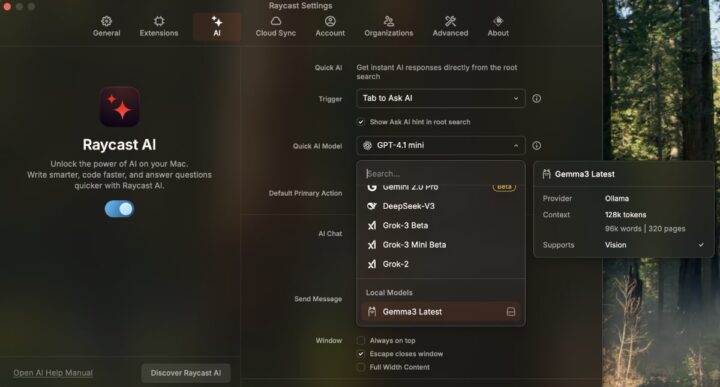

Nun müsst ihr euch noch für ein Modell entscheiden, dass ihr auf dem Mac installiert. Je nachdem, welche Hardware ihr habt, könnt ihr größere oder eben kleinere Modelle nutzen. Ein Leichtgewicht ist beispielsweise Googles Gemma3. Die zur Verfügung stehenden Modelle findet ihr direkt bei Ollama. Ihr gebt nun entweder im Terminal den Befehl zum Pull des Modells ein oder nutzt die Raycast-Oberfläche zum Download in den Einstellungen.

Ist das erledigt, habt ihr ab sofort in den Einstellungen für Quick-AI oder im AI-Chat die Möglichkeit das lokale Modell auszuwählen. Ihr erkennt die auf eurem Mac befindlichen Modelle an einem Disk-Symbol rechts daneben. Gerade wenn man kein Abo bei Raycast abschließen möchte, ist das eine gute Alternative dennoch AI-Befehle (beispielsweise Rechtschreibfehler aus Texten holen, Zusammenfassungen erstellen etc.) und Quick-AI nutzen zu können.

Die Nutzung in AI-Extension ist aktuell noch im Test, kann aber auf Wunsch auch in den Einstellungen aktiviert werden. Stellt euch hierbei aber noch auf Fehler ein, da die lokalen Modelle noch Probleme mit Tool-Calls haben.

Probiert es ruhig mal aus und lasst gern Feedback da.

Transparenz: In diesem Artikel sind Partnerlinks enthalten. Durch einen Klick darauf gelangt ihr direkt zum Anbieter. Solltet ihr euch dort für einen Kauf entscheiden, erhalten wir eine kleine Provision. Für euch ändert sich am Preis nichts. Partnerlinks haben keinerlei Einfluss auf unsere Berichterstattung.

Schade, dass es keine Firefox Integration gibt. Wär genau, was ich gesucht habe

zumindest mit Ollama lokal funktioniert das in Firefox mit nomic-embed-text (zusätzlich in Ollama installieren) und der Page assist Erweiterung für Firefox. Sieht dann aus wie ChatGPT in Firefox und kann auch in nem Netzwerk genutzt werden. Sollte damit auch funktionieren.